Real Identities Can Be Recovered From Synthetic Datasets

Terwijl 2022 het moment markeerde waarop het ontwrichtende potentieel van generatieve AI voor het eerst brede publieke aandacht trok, was 2024 het jaar waarin vragen over de wettigheid van de onderliggende gegevens centraal stonden bij bedrijven die graag de macht ervan wilden benutten.

De VS Fair Use-doctrinesamen met de impliciete wetenschappelijke licentie die academische en commerciële onderzoekssectoren lange tijd in staat had gesteld generatieve AI te verkennen, werd steeds onhoudbaarder naarmate de toenemende bewijs van plagiaat opgedoken. Vervolgens hebben de VS voorlopig niet toegestaan Door AI gegenereerde inhoud is niet auteursrechtelijk beschermd.

Deze zaken zijn nog lang niet opgelost, en nog lang niet op korte termijn opgelost; in 2023, gedeeltelijk als gevolg van groeiende media en publieke bezorgdheid over de juridische status van door AI gegenereerde output is het Amerikaanse Copyright Office een jarenlang onderzoek gestart naar dit aspect van generatieve AI. het eerste segment (betreffende digitale replica’s) in juli 2024.

Intussen blijven de belangen van het bedrijfsleven gefrustreerd door de mogelijkheid dat de dure modellen die zij willen exploiteren hen blootstellen aan juridische gevolgen wanneer er uiteindelijk definitieve wetgeving en definities komen.

De dure kortetermijnoplossing is geweest om generatieve modellen te legitimeren door ze te trainen op basis van gegevens die bedrijven mogen exploiteren. Adobe’s tekst-naar-afbeelding (en nu tekst-naar-video) Firefly-architectuur wordt voornamelijk aangedreven door zijn aankoop van de Fotolia stockbeelddataset in 2014, aangevuld door het gebruik van auteursrechtelijk beschermde gegevens uit het publieke domein*. Tegelijkertijd hebben gevestigde stockfotoleveranciers zoals Getty en Shutterstock dat ook gedaan met een hoofdletter over de nieuwe waarde van hun gelicentieerde gegevens, met een groeiend aantal deals om inhoud in licentie te geven of anders hun eigen IP-compatibele GenAI-systemen te ontwikkelen.

Synthetische oplossingen

Sinds het verwijderen van auteursrechtelijk beschermde gegevens van de getraind latente ruimte van een AI-model vol problemen zit, kunnen fouten op dit gebied mogelijk zeer kostbaar zijn voor bedrijven die experimenteren met consumenten- en bedrijfsoplossingen die gebruik maken van machinaal leren.

Een alternatieve en veel goedkopere oplossing voor computervisiesystemen (en Ook Large Language Models, of LLMs), is het gebruik van synthetische data, waarbij de dataset is samengesteld uit willekeurig gegenereerde voorbeelden van het doeldomein (zoals gezichten, katten, kerken of zelfs een meer algemene dataset).

Sites zoals thispersondoesnotexist.com hebben lang geleden het idee gepopulariseerd dat authentiek ogende foto’s van ‘niet-echte’ mensen kunnen worden gesynthetiseerd (in dat specifieke geval via Generative Adversarial Networks of GAN’s) zonder enige relatie te hebben met mensen die daadwerkelijk bestaan in de echte wereld.

Als je een gezichtsherkenningssysteem of een generatief systeem traint op zulke abstracte en niet-reële voorbeelden, kun je dus in theorie een fotorealistische productiviteitsstandaard voor een AI-model verkrijgen zonder dat je hoeft na te denken of de gegevens juridisch bruikbaar zijn.

Evenwichtswet

Het probleem is dat de systemen die synthetische gegevens produceren, zelf zijn getraind op basis van echte gegevens. Als sporen van die gegevens doordringen in de synthetische gegevens, levert dit mogelijk bewijs op dat beperkt of anderszins ongeoorloofd materiaal is uitgebuit voor geldelijk gewin.

Om dit te voorkomen, en om echt ‘willekeurige’ beelden te produceren, moeten dergelijke modellen ervoor zorgen dat ze goedgegeneraliseerd. Generalisatie is de maatstaf voor het vermogen van een getraind AI-model om concepten op hoog niveau intrinsiek te begrijpen (zoals ‘gezicht’, ‘man’of ‘vrouw’) zonder toevlucht te nemen tot het repliceren van de daadwerkelijke trainingsgegevens.

Helaas kan het voor getrainde systemen lastig zijn om korrelige details tenzij het behoorlijk uitgebreid traint op een dataset. Hierdoor wordt het systeem blootgesteld aan risico’s onthouden: een neiging om tot op zekere hoogte voorbeelden van de daadwerkelijke trainingsgegevens te reproduceren.

Dit kan worden verzacht door een meer ontspannen instelling in te stellen leersnelheidof door de training te beëindigen in een stadium waarin de kernconcepten nog steeds ductiel zijn en niet geassocieerd zijn met een specifiek datapunt (zoals een specifiek beeld van een persoon, in het geval van een gezichtsdataset).

Beide remedies zullen echter waarschijnlijk leiden tot modellen met minder fijnkorrelige details, omdat het systeem geen kans heeft gekregen om verder te gaan dan de ‘basis’ van het doeldomein en tot in de details.

Daarom worden in de wetenschappelijke literatuur over het algemeen zeer hoge leerpercentages en uitgebreide trainingsschema’s toegepast. Hoewel onderzoekers in het uiteindelijke model doorgaans proberen een compromis te sluiten tussen brede toepasbaarheid en granulariteit, kunnen zelfs enigszins ‘uit het hoofd geleerde’ systemen zichzelf vaak verkeerd voorstellen als goed gegeneraliseerd – zelfs in de eerste tests.

Gezicht onthullen

Dit brengt ons bij een interessant nieuw artikel uit Zwitserland, dat beweert de eerste te zijn die aantoont dat de originele, echte afbeeldingen die de synthetische gegevens aandrijven, kunnen worden teruggevonden uit gegenereerde afbeeldingen die in theorie volledig willekeurig zouden moeten zijn:

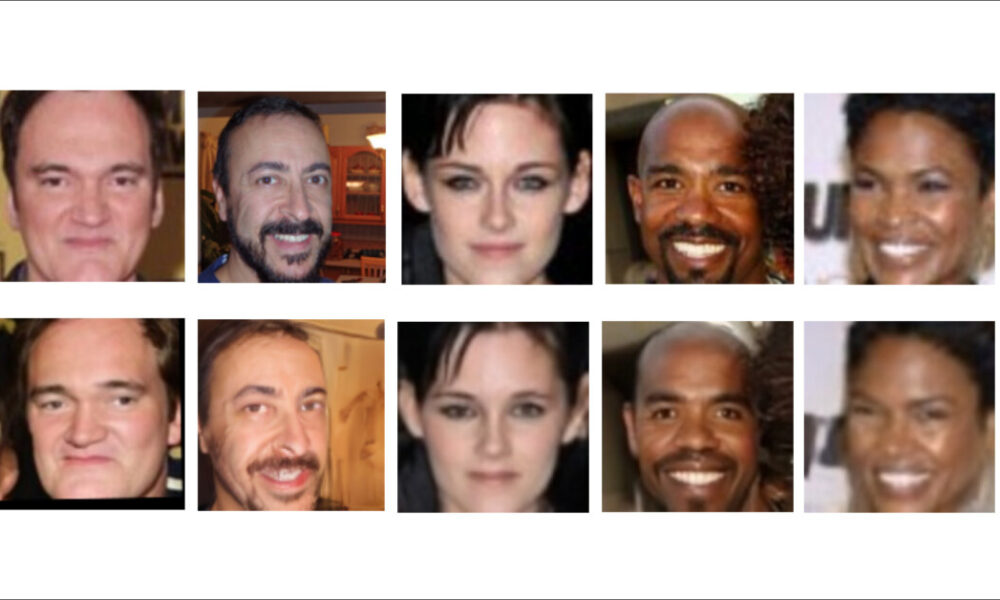

Voorbeeldgezichtsafbeeldingen gelekt uit trainingsgegevens. In de rij hierboven zien we de originele (echte) afbeeldingen; in de rij hieronder zien we willekeurig gegenereerde afbeeldingen, die aanzienlijk overeenkomen met de echte afbeeldingen. Bron: https://arxiv.org/pdf/2410.24015

De resultaten, zo stellen de auteurs, geven aan dat ‘synthetische’ generatoren inderdaad een groot aantal van de trainingsgegevenspunten hebben onthouden, in hun zoektocht naar grotere granulariteit. Ze geven ook aan dat systemen die afhankelijk zijn van synthetische gegevens om AI-producenten te beschermen tegen juridische gevolgen in dit opzicht zeer onbetrouwbaar kunnen zijn.

De onderzoekers voerden een uitgebreide studie uit op zes geavanceerde synthetische datasets, waaruit bleek dat in alle gevallen originele (potentieel auteursrechtelijk beschermde of beschermde) gegevens kunnen worden hersteld. Zij geven commentaar:

‘Onze experimenten tonen aan dat state-of-the-art datasets voor synthetische gezichtsherkenning monsters bevatten die zeer dicht bij de monsters liggen in de trainingsgegevens van hun generatormodellen. In sommige gevallen bevatten de synthetische monsters kleine wijzigingen in het originele beeld, maar we kunnen ook waarnemen dat in sommige gevallen het gegenereerde monster meer variatie bevat (bijvoorbeeld een andere pose, lichtomstandigheden, enz.) terwijl de identiteit behouden blijft.

‘Dit suggereert dat de generatormodellen de identiteitsgerelateerde informatie uit de trainingsgegevens leren en onthouden en soortgelijke identiteiten kunnen genereren. Dit schept kritische zorgen over de toepassing van synthetische data bij privacygevoelige taken, zoals biometrie en gezichtsherkenning.’

De papier is getiteld Onthulling van synthetische gezichten: hoe synthetische datasets echte identiteiten kunnen blootleggenen is afkomstig van twee onderzoekers van het Idiap Research Institute in Martigny, de École Polytechnique Fédérale de Lausanne (EPFL) en de Université de Lausanne (UNIL) in Lausanne.

Methode, gegevens en resultaten

De onthouden gezichten in het onderzoek werden onthuld door Membership Inference Attack. Hoewel het concept ingewikkeld klinkt, spreekt het redelijk voor zich: het afleiden van lidmaatschap verwijst in dit geval naar het proces van het in twijfel trekken van een systeem totdat het gegevens onthult die overeenkomen met de gegevens waarnaar u op zoek bent, of er aanzienlijk op lijken.

Verdere voorbeelden van afgeleide gegevensbronnen uit het onderzoek. In dit geval zijn de synthetische bronafbeeldingen afkomstig uit de DCFace-gegevensset.

De onderzoekers bestudeerden zes synthetische datasets waarvan de (echte) datasetbron bekend was. Omdat zowel de echte als de valse datasets in kwestie allemaal een zeer groot aantal afbeeldingen bevatten, is dit in feite hetzelfde als zoeken naar een speld in een hooiberg.

Daarom gebruikten de auteurs een kant-en-klaar gezichtsherkenningsmodel† met een ResNet100 ruggengraat getraind op de AdaFace verlies functie (op de WebFace12M gegevensset).

De zes gebruikte synthetische datasets waren: DCFace (een latent diffusiemodel); IDiff-gezicht (Uniform – een diffusiemodel gebaseerd op FFHQ); IDiff-Face (tweetraps – een variant die een andere bemonsteringsmethode gebruikt); GANDiffGezicht (gebaseerd op Generative Adversarial Networks en Diffusion-modellen, met behulp van StijlGAN3 om initiële identiteiten te genereren, en vervolgens DroomBooth om gevarieerde voorbeelden te creëren); IDNet (een GAN-methode, gebaseerd op StijlGAN-ADA); En SGezicht (een identiteitsbeschermend raamwerk).

Omdat GANDiffFace zowel GAN- als diffusiemethoden gebruikt, werd deze vergeleken met de trainingsdataset van StyleGAN – de oorsprong die dit netwerk het dichtst benadert.

De auteurs hebben synthetische datasets uitgesloten die gebruik maken van CGI in plaats van AI-methoden, en hebben bij het evalueren van de resultaten de overeenkomsten voor kinderen buiten beschouwing gelaten, vanwege distributieafwijkingen in dit opzicht, evenals niet-gezichtsafbeeldingen (die vaak kunnen voorkomen in gezichtsgegevenssets, waar web-scraping systemen produceren valse positieven voor objecten of artefacten met gezichtsachtige eigenschappen).

Cosinus-overeenkomst werd berekend voor alle opgehaalde paren en samengevoegd tot histogrammen, hieronder geïllustreerd:

Een histogramweergave voor cosinus-gelijkenisscores berekend over de diverse datasets, samen met hun gerelateerde waarden van gelijkenis voor de top-k-paren (verticale stippellijnen).

Het aantal overeenkomsten wordt weergegeven in de pieken in de bovenstaande grafiek. Het artikel bevat ook voorbeeldvergelijkingen van de zes datasets en de bijbehorende geschatte afbeeldingen in de originele (echte) datasets, waarvan hieronder enkele selecties worden weergegeven:

Voorbeelden van de vele voorbeelden die in het bronpapier zijn weergegeven, waarnaar de lezer wordt verwezen voor een uitgebreidere selectie.

Het papier geeft commentaar:

‘[The] de gegenereerde synthetische datasets bevatten zeer vergelijkbare afbeeldingen uit de trainingsset van hun generatormodel, wat aanleiding geeft tot bezorgdheid over het genereren van dergelijke identiteiten.’

De auteurs merken op dat voor deze specifieke aanpak het opschalen naar datasets met een groter volume waarschijnlijk inefficiënt zal zijn, omdat de noodzakelijke berekeningen uiterst belastend zouden zijn. Ze merken verder op dat visuele vergelijking nodig was om overeenkomsten af te leiden, en dat de geautomatiseerde gezichtsherkenning alleen waarschijnlijk niet voldoende zou zijn voor een grotere taak.

Met betrekking tot de implicaties van het onderzoek, en met het oog op de toekomst, luidt het werk als volgt:

‘[We] wil benadrukken dat de belangrijkste motivatie voor het genereren van synthetische datasets het aanpakken van privacyproblemen bij het gebruik van grootschalige, op internet gecrawlde gezichtsdatasets is.

‘Daarom leidt het lekken van gevoelige informatie (zoals de identiteit van echte afbeeldingen in de trainingsgegevens) in de synthetische dataset tot kritische zorgen over de toepassing van synthetische gegevens voor privacygevoelige taken, zoals biometrie. Onze studie werpt licht op de privacyvalkuilen bij het genereren van datasets voor synthetische gezichtsherkenning en maakt de weg vrij voor toekomstig onderzoek naar het genereren van verantwoorde datasets voor synthetische gezichtsherkenning.’

Hoewel de auteurs een code-release voor dit werk beloven op de projectpaginais er momenteel geen link naar de repository.

Conclusie

De laatste tijd heeft de media-aandacht de nadruk gelegd op de afnemende rendementen verkregen door het trainen van AI-modellen op basis van door AI gegenereerde gegevens.

Het nieuwe Zwitserse onderzoek brengt echter een overweging onder de aandacht die mogelijk urgenter is voor het groeiende aantal bedrijven dat gebruik wil maken van en profiteren van generatieve AI: het voortbestaan van IP-beschermde of ongeautoriseerde datapatronen, zelfs in datasets die dat wel zijn. ontworpen om deze praktijk te bestrijden. Als we het een definitie zouden moeten geven, zou het in dit geval ‘face-washing’ kunnen worden genoemd.

* Het besluit van Adobe om door gebruikers geüploade, door AI gegenereerde afbeeldingen naar Adobe Stock toe te staan, heeft echter feitelijk de juridische ‘zuiverheid’ van deze gegevens ondermijnd. Bloomberg betoogde in april 2024 waren door de gebruiker aangeleverde afbeeldingen van het generatieve AI-systeem van MidJourney opgenomen in de mogelijkheden van Firefly.

† Dit model wordt niet geïdentificeerd in het document.

Voor het eerst gepubliceerd op woensdag 6 november 2024